来源:https://www.cnblogs.com/weiluoyan/p/11772319.html

以下为复制内容:

我们这个项目有个接口因为数据比较多,返回的json串就特别长,你用curl调这个接口,发现返回的json串被截断。

解决:

- 1、首先查看nginx的error日志,会有报错提示,类似:nginx的目录明下的文件 failed(13: Permission denied) while reading upstream, client:...,server:…

- 2、看报错提示是没有权限,原因就是nginx存在一个buffer的机制,在数据过大超出缓冲区的 最大容量,会将数据写入临时文件(临时目录),而此时如果你安装的nginx的用户权限不是 服务器权限,就会报没有权限的问题,因为此时没有权限,所以再返回时,超出缓冲区的数据将丢失, 就会出现截断。

- 3、最后将nginx的目录赋予权限就可以了

- 4、执行操作: sudo chown -R www:root nginx目录名称 chmod -R 764 /usr/local/nginx/临时目录名称

补充:

对于来自fastcgi server的response,nginx将其缓冲到内存中,然后依次发送到客户端浏览器,缓冲区的大小由fastcgi_buffers和fasecgi_buffer_size两个值控制,比如一下配置:fastcgi_buffer 8 128;此处代表nginx设置8个128k的块进行缓存,总共大小是8*128k

fastcgi_buffer_size 128k; 此处代表每块大小,用于指定读取fastcgi应答第一部分需要用 多大的缓冲区,这个值表示将使用1个128kb的缓冲区读取应答的一部分(应答头),可以设置 为fastcgi_buffers选项指定的缓冲区大小。

fastcgi_buffers : 指定本地需要用多少和多大的缓冲区来缓冲FastCGI的应答请求。如果一个PHP脚本所产生的页面大小为256KB,那么会为其分配4个64KB的缓冲区来缓存; 如果页面大小大于256KB,那么大于256KB的部分会缓存到fastcgi_temp指定的路径中, 但是这并不是好方法,因为内存中的数据处理速度要快于硬盘。一般这个值应该为站点中PHP脚本 所产生的页面大小的中间值,如果站点大部分脚本所产生的页面大小为256KB,那么可以把这个值 设置为“16 16k”、“4 64k”等。

所以总计能创建的最大内存缓冲区大小是 464K+64K = 320k。而这些缓冲区是根据实际的 Response 大小动态生成的,并不是一次性创建的。比如一个 128K 的页面,Nginx 会创建 264K 共 2 个 buffers。

当 Response 小于等于 320k 时,所有数据当然全部在内存中处理。如果 Response 大于 320k 呢? fastcgi_temp 的作用就在于此。多出来的数据会被临时写入到文件中,放在这个目录下面。

内存中缓冲了 320K,剩下的会写入的文件中。而实际的情况是,运行 Nginx Process 的用户并没有fastcgi_temp 目录的写权限,于是剩下的数据就丢失掉了。

以上就是对自己遇到的一个问题做了一个总结。

以下为原创内容:

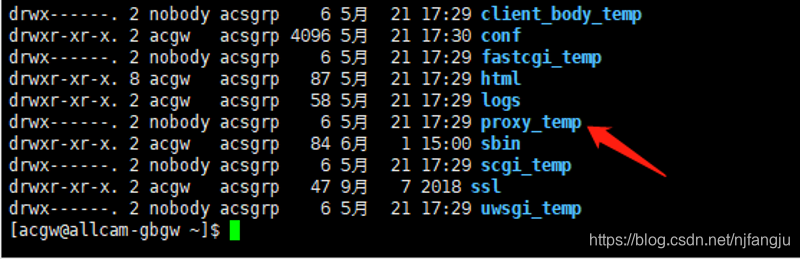

在实战中遇到的问题并没有通过修改nginx配置文件解决,加了相关配置依然会有同样的问题,然后修改了acgw的临时目录 proxy_temp 的权限才将问题解决:

本来是nobody:acsgrp 改成了acgw:acsgrp

原因:nginx对于小的反向代理请求是使用内存作中转,对于稍微大一点的,是使用临时文件系统来做中转的,临时文件目录/usr/local/nginx/proxy_temp,而对这个目录没有读写权限,导致数据不全。

解决:然后让运维看了下nginx的日志和目录权限,发现确实如此,给临时文件目录加上读写权限,搞定。

来源:https://blog.csdn.net/njfangju/article/details/106772846

相关推荐

主要介绍了解决vue net :ERR_CONNECTION_REFUSED报错问题,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧

在Google chrome开发人员控制台中一直报此错误。(虽然只是一个警告,但是体验还是非常不好) 先说解决方案: 第一种: 在Google chrome浏览器调试工具中,设置该调试工具,点开之后选择Settings 关闭此选项 ...

主要介绍了解决Chrome在新版MacOS上报错 NET::ERR_CERT_WEAK_KEY 的问题,本文给大家介绍的非常详细,对大家的学习或工作具有一定的参考借鉴价值,需要的朋友可以参考下

解决tomcat配置ssl错误的解决办法,不一定有用,只是一个备份。不需要分就是因为不一定能帮到谁。

ajaxFileUpload 博文链接:https://raising.iteye.com/blog/2233668

burp的Cert证书

问题:wx.requset请求出错net::ERR_CONNECTION_RESET 源代码如下: wx.request({ url: 'https://www.dinggestyle.com/API/GetOrgList', data: { OrgType: 0 }, method: 'GET', success: function (res) { ... ...

ERR_CONNECTION_RESET的解释是:ERR-错误CONNECTION-连接-RESET-重复 Google没有对此错误的解决方案因此会再次提示用户这个网站含有未知错误

这个错误是在Master进程向子进程send消息时发现pipe已经关闭了的情况下由Master进程报出来的。 2019-12-16 14:33:02,pid-170096, Error [ERR_IPC_CHANNEL_CLOSED]: channel closed at ChildProcess.target.send ...

很不错的回顶回底JavaScript技术,希望大家喜欢

自己看的,附带uniapp证书制作

微信扫码支付和支付宝扫码支付代码,在我自己的项目中用的,仅供参考,代码是java写的,action用的springMVC技术,这个代码只是项目中的其中两个action类

解决电脑连接正常,但浏览器无法打开网页的问题

Ext项目Ext的插件都斗劲大,对于网页的浏览速度也是很是不容乐观的,于是就须要对所加载的js文件进行优化,此中一个办法就是对于较大的js文件可以进行紧缩。紧缩成gzjs格局,然则gzjs后缀名的文件又不克不及被浏览器...

rtl8188eu_r16m_20161208初步验证通过_没有...[ 30.993687] hci: ERR: not support sunxi_usb_enable_ehci [ 30.999650] hci: ERR: not support sunxi_usb_enable_ohci shell@astar-evb30:/ $ shell@astar-evb30:/ $

open source c log. from github. its fast logger .

对网络请求进行封装:文件目录为 network / request.js 使用方法: ...}).catch(err => { //打印错误信息 console.log(err) })。 详情参考:https://mp.csdn.net/mp_blog/creation/editor/124558480