- 为何有些公司在机器学习业务方面倾向使用 R + Hadoop方案?

- 你不知道的十个Hadoop的应用场景

- Hadoop教程:Hadoop的源起和体系架构

- Hadoop教程:Hadoop核心架构详细解析

- Hadoop教程:Hadoop集群和网络的基本原理(一)

- Hadoop教程:Hadoop集群和网络的基本原理(二)

- Hadoop教程:Hadoop集群和网络的基本原理(三)

- Hadoop教程:Hadoop基本流程和代码范例

- Hadoop教程:SQL Server+Hadoop变身大数据解决方案

- Hadoop教程:谈百度是如何使用hadoop的,并做了哪些改进

- Hadoop教程:Smartbi在Hadoop大数据分析中的应用

- Hadoop教程:PayPal的Hadoop迭代式计算框架--Guagua

- Hadoop教程:8个值得关注的SQL-on-Hadoop框架

- Hadoop教程:四个方案将OpenStack部署到Hadoop

- Hadoop教程:Hadoop的技术生态圈

- Oracle大数据SQL使SQL、Hadoop和NoSQL融合互通

- Hadoop教程:Hadoop集群环境下的网络架构设计与优化

- Hadoop教程:9款Hadoop商业发行版的调研报告

- Hadoop教程:Hadoop分布式环境搭建

- Hadoop教程:Teradata Aster在Hadoop和R上的进展

- Hadoop和大数据是合并还是冲突?

- Hadoop教程:Hadoop数据传输工具Sqoop

- Hadoop教程:大数据处理平台Hadoop能为企业带来什么?

- Hadoop教程:Hadoop和大数据在电信业里的典型应用

- Hadoop教程:Hadoop在大数据中的角色

- Hadoop教程:Hadoop平台的基本组成与生态系统

- Hadoop教程:当机器大数据遇见Hadoop

- Hadoop教程:Hadoop系统分布式存储与并行计算构架

- Hadoop教程:用外部存储构建Hadoop

- Hadoop教程:用hadoop计算PI值

- Hadoop教程:Hadoop扩展过程中的潜在危机

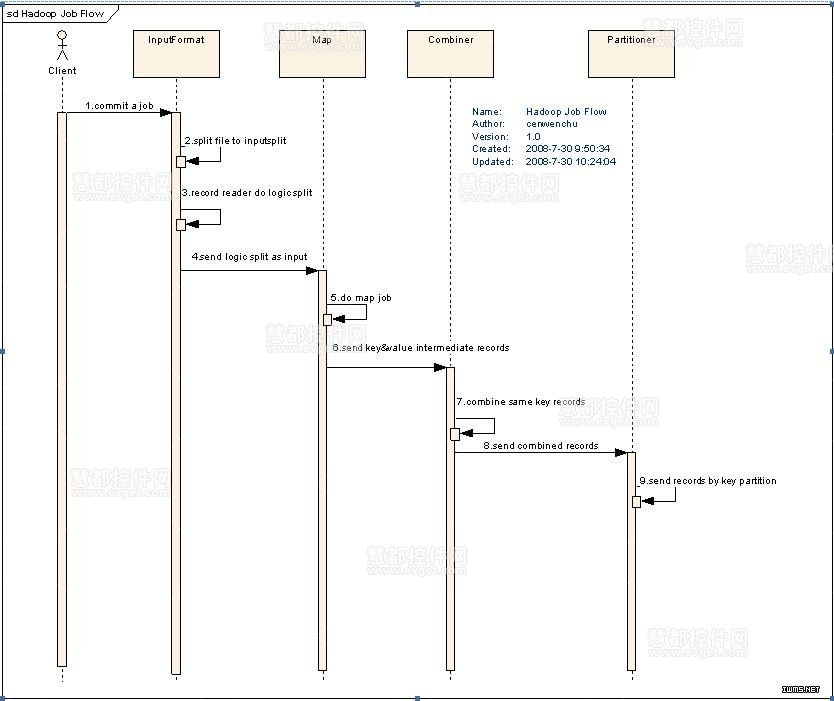

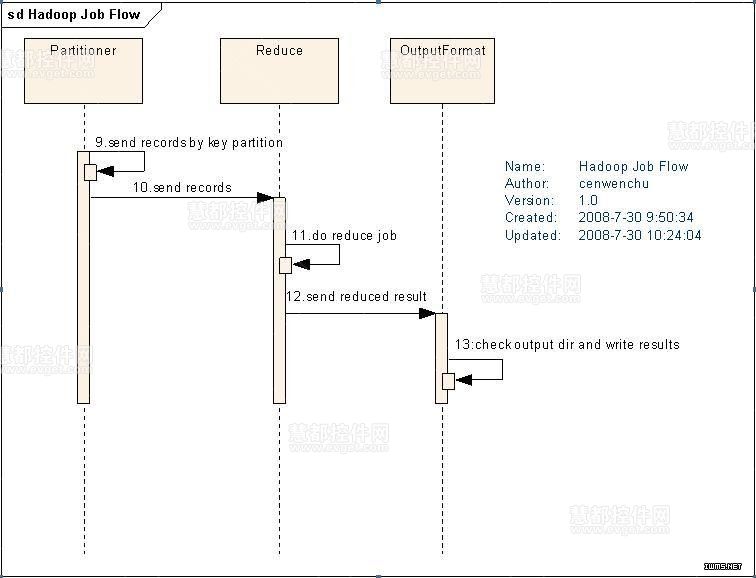

基本流程:

一个图片太大了,只好分割成为两部分。根据流程图来说一下具体的一个任务执行的情况。

1. 分布式环境中客户端创建任务并提交。

2. InputFormat做Map前的预处理,主要负责以下工作:

a) 验证输入的格式是否符合JobConfig的输入定义,这个在实现Map和构建Conf的时候就会知道,不定义可以是Writable的任意子类。

b) 将input的文件split为逻辑上的输入InputSplit,其实这就是在上面提到的在分布式文件系统中blocksize是有大小限制的,因此大文件会被划分为多个block。

c) 通过RecordReader来再次处理inputsplit为一组records,输出给Map。(inputsplit只是逻辑切分的第一步,但是如何根据文件中的信息来切分还需要RecordReader来实现,例如最简单的默认方式就是回车换行的切分)

3. RecordReader处理后的结果作为Map的输入,Map执行定义的Map逻辑,输出处理后的key,value对到临时中间文件。

4. Combiner可选择配置,主要作用是在每一个Map执行完分析以后,在本地优先作Reduce的工作,减少在Reduce过程中的数据传输量。

5. Partitioner可选择配置,主要作用是在多个Reduce的情况下,指定Map的结果由某一个Reduce处理,每一个Reduce都会有单独的输出文件。(后面的代码实例中有介绍使用场景)

6. Reduce执行具体的业务逻辑,并且将处理结果输出给OutputFormat。

7. OutputFormat的职责是,验证输出目录是否已经存在,同时验证输出结果类型是否如Config中配置,最后输出Reduce汇总后的结果。

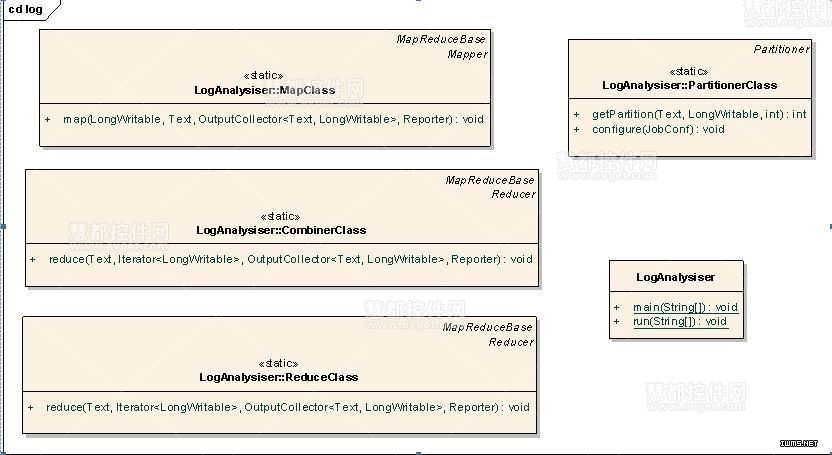

代码范例:

业务场景描述:

可设定输入和输出路径(操作系统的路径非HDFS路径),根据访问日志分析某一个应用访问某一个API的总次数和总流量,统计后分别输出到两个文件中。

仅仅为了测试,因此没有去细分很多类,将所有的类都归并于一个类便于说明问题。

图4 测试代码类图

LogAnalysiser就是主类,主要负责创建,提交任务,并且输出部分信息。内部的几个子类用途可以参看流程中提到的角色职责。具体的看看几个类和方法的代码片断:

LogAnalysiser::MapClass

public static class MapClass extends MapReduceBase

implements Mapper<longwritable, text,="" longwritable="" style="box-sizing: border-box;">

{

public void map(LongWritable key, Text value, OutputCollector<text, longwritable="" style="box-sizing: border-box;"> output, Reporter reporter)

throws IOException

&

相关推荐

Hadoop教程.pdf

大数据Hadoop视频教程大数据Hadoop视频教程大数据Hadoop视频教程

hadoop教程ppt.ppt

01_hadoop_hdfs1分布式文件系统01 02_hadoop_hdfs1分布式文件系统02 03_hadoop_hdfs1分布式文件系统03 04_hadoop_hdfs1分布式文件系统04 05_hadoop_hdfs1分布式文件系统05 06_hadoop_hdfs1分布式文件系统06 07_...

第一天 hadoop的基本概念 伪分布式hadoop集群安装 hdfs mapreduce 演示 01-hadoop职位需求状况.avi 02-hadoop课程安排.avi 03-hadoop应用场景.avi 04-hadoop对海量数据处理的解决思路.avi 05-hadoop版本选择和...

很不错的hadoop基础教程,就是书有点老了,可以作为基础拿来看

hadoop教程.ppt

Hadoop分析气象数据完整版源代码(含Hadoop的MapReduce代码和SSM框架) 《分布式》布置了一道小作业,这是作业的所有代码,里面包含了Hadoop的MapReduce代码、和SSM框架显示数据的代码

Hadoop安装教程_单机/伪分布式配置_Hadoop2.7.1/Ubuntu 16.04

Hadoop源代码eclipse编译教程

Hadoop技术答疑汇总

Apache Hadoop 教程(英文版),高清文字版,详细教程。

Hadoop集群程序设计与开发教材最终代码.zip

Hadoop自学书籍汇总

hadoop 分布式部署详细教程,操作不走说明写的很详细

windows上安装hadoop教程,详细介绍了安装规则。

将自己学习hadoop的资料汇总一下,总共是五本教程,希望对大家有所帮助。

大数据之Hadoop学习教程+笔记合计_超详细完整.zip

从零教你在Linux环境下编译hadoop2.4及hadoop2.4汇总

hadoop系列教程详细讲解hadoop的安装和实例讲解,包括HDFS和MapReduce的实例。