آ

آ access pattern in spark storage

آ

آ

آ

آ

آ [1]

هˆ°ç›®ه‰چن¸؛و¢ï¼Œوˆ‘ن»¬ه·²ç»ڈن؛†è§£ن؛†sparkو€ژن¹ˆن½؟用JVMçڑ„ه†…هکن»¥هڈٹ集群ن¸ٹو‰§è،Œو§½وک¯ن»€ن¹ˆï¼Œç›®ه‰چن¸؛و¢è؟کو²،وœ‰è°ˆهˆ°taskçڑ„ن¸€ن؛›ç»†èٹ‚,è؟™ه°†هœ¨هڈ¦ن¸€ن¸ھو–‡ç« ن¸وڈگé«ک,هں؛وœ¬ن¸ٹه°±وک¯sparkçڑ„ن¸€ن¸ھه·¥ن½œهچ•ه…ƒï¼Œن½œن¸؛exectorçڑ„jvmè؟›ç¨‹ن¸çڑ„ن¸€ن¸ھç؛؟程و‰§è،Œï¼Œè؟™ن¹ںوک¯ن¸؛ن»€ن¹ˆsparkçڑ„jobهگ¯هٹ¨و—¶é—´ه؟«çڑ„هژںه› ,هœ¨jvmن¸هگ¯هٹ¨ن¸€ن¸ھç؛؟程و¯”هگ¯هٹ¨ن¸€ن¸ھهچ•ç‹¬çڑ„jvmè؟›ç¨‹ه—(هœ¨hadoopن¸و‰§è،Œmapreduceه؛”用ن¼ڑهگ¯هٹ¨ه¤ڑن¸ھjvmè؟›ç¨‹ï¼‰آ

ن¸‹é¢ه°†ه…³و³¨sparkçڑ„هڈ¦ن¸€ن¸ھوٹ½è±،ï¼ڑpartition, sparkه¤„çگ†çڑ„و‰€وœ‰و•°وچ®éƒ½ن¼ڑهˆ‡هˆ†وˆگpartion,ن¸€ن¸ھparitionوک¯ن»€ن¹ˆن»¥هڈٹو€ژن¹ˆç،®ه®ڑ,partitionçڑ„ه¤§ه°ڈه®Œه…¨ن¾èµ–و•°وچ®و؛گ,sparkن¸ه¤§éƒ¨هˆ†ç”¨ن؛ژ读هڈ–و•°وچ®çڑ„و–¹و³•éƒ½هڈ¯ن»¥وŒ‡ه®ڑç”ںوˆگçڑ„RDDن¸partitionçڑ„ن¸ھو•°ï¼Œه½“ن»ژhdfsن¸ٹ读هڈ–ن¸€ن¸ھو–‡ن»¶و—¶ï¼Œن¼ڑن½؟用Hadoopçڑ„InputFormatو¥ه¤„çگ†ï¼Œé»ک认وƒ…ه†µن¸‹InputFormatè؟”ه›و¯ڈن¸ھInputSplit都ن¼ڑوک ه°„RDDن¸çڑ„ن¸€ن¸ھPartition,ه¤§éƒ¨هˆ†هکه‚¨هœ¨HDFSن¸ٹçڑ„و–‡ن»¶و¯ڈن¸ھو•°وچ®ه—ن¼ڑç”ںوˆگن¸€ن¸ھInputSplit,و¯ڈن¸ھو•°وچ®ه—ه¤§ه°ڈن¸؛64mbه’Œ128mb,ه› ن¸؛HDFSن¸ٹé¢çڑ„و•°وچ®çڑ„ه—边界وک¯وŒ‰ه—èٹ‚و¥ç®—çڑ„(64mbن¸€ن¸ھه—),ن½†وک¯ه½“و•°وچ®è¢«ه¤„çگ†وک¯ï¼Œه®ƒهڈˆè¦پوŒ‰è®°ه½•è؟›è،Œهˆ‡هˆ†ï¼Œه¯¹ن؛ژو–‡وœ¬و–‡ن»¶و¥è¯´هˆ‡هˆ†çڑ„ه—符ه°±وک¯وچ¢è،Œç¬¦ï¼Œه¯¹ن؛ژsequenceو–‡ن»¶و¥è¯´ï¼Œن»–وک¯ه—结وں,ه¦‚وœوک¯هژ‹ç¼©و–‡ن»¶ï¼Œو•´ن¸ھو–‡ن»¶éƒ½è¢«هژ‹ç¼©ن؛†ï¼Œه®ƒن¸چ能وŒ‰è،Œè؟›è،Œهˆ‡هˆ†ن؛†ï¼Œو•´ن¸ھو–‡ن»¶هڈھوœ‰ن¸€ن¸ھinputsplit,è؟™و ·sparkن¸ن¹ںن¼ڑهڈھوœ‰ن¸€ن¸ھparition,هœ¨ه¤„çگ†çڑ„و—¶ه€™éœ€è¦پو‰‹هٹ¨çڑ„repatitionم€‚

آ آ [1]

آ

آ

هœ¨Sparkه†…部,هچ•ن¸ھexecutorè؟›ç¨‹ه†…RDDçڑ„هˆ†ç‰‡و•°وچ®وک¯ç”¨Iteratorوµپه¼ڈè®؟é—®çڑ„,Iteratorçڑ„hasNextو–¹و³•ه’Œnextو–¹و³•وک¯ç”±RDD lineageن¸ٹهگ„ن¸ھtransformationوگ؛ه¸¦çڑ„é—هŒ…ه‡½و•°ه¤چهگˆè€Œوˆگçڑ„م€‚该ه¤چهگˆIteratorو¯ڈè®؟é—®ن¸€ن¸ھه…ƒç´ ,ه°±ه¯¹è¯¥ه…ƒç´ ه؛”用相ه؛”çڑ„ه¤چهگˆه‡½و•°ï¼Œه¾—هˆ°çڑ„结وœه†چوµپه¼ڈهœ°èگ½هœ°ï¼ˆه¯¹ن؛ژshuffle stageوک¯èگ½هœ°هˆ°وœ¬هœ°و–‡ن»¶ç³»ç»ںç•™ه¾…هگژç»stageè®؟问,ه¯¹ن؛ژresult stageوک¯èگ½هœ°هˆ°HDFSوˆ–é€په›driver端ç‰ç‰ï¼Œè§†é€‰ç”¨çڑ„action而ه®ڑ)م€‚ه¦‚وœç”¨وˆ·و²،وœ‰è¦پو±‚Spark cache该RDDçڑ„结وœï¼Œé‚£ن¹ˆè؟™ن¸ھè؟‡ç¨‹هچ 用çڑ„ه†…هکوک¯ه¾ˆه°ڈçڑ„,ن¸€ن¸ھه…ƒç´ ه¤„çگ†ه®Œو¯•هگژه°±èگ½هœ°وˆ–و‰”وژ‰ن؛†ï¼ˆو¦‚ه؟µن¸ٹه¦‚و¤ï¼Œه®çژ°ن¸ٹوœ‰buffer),ه¹¶ن¸چن¼ڑé•؟ن¹…هœ°هچ 用ه†…هکم€‚هڈھوœ‰هœ¨ç”¨وˆ·è¦پو±‚Spark cache该RDD,ن¸”storage levelè¦پو±‚هœ¨ه†…هکن¸cacheو—¶ï¼ŒIteratorè®،ç®—ه‡؛çڑ„结وœو‰چن¼ڑ被ن؟留,é€ڑè؟‡cache managerو”¾ه…¥ه†…هکو± م€‚

相ه…³وژ¨èچگ

ه¤§و•°وچ®ç»„ن»¶-监وژ§-spark-driver/executorو€§èƒ½çڑ„prometheus-grafanaو¨،و؟وڈ’ن»¶

pysparkوœ¬هœ°çڑ„çژ¯ه¢ƒé…چç½®هŒ…,spark-2.3.4-bin-hadoop2.7.tgzï¼ڑspark-2.3.4-bin-hadoop2.7.tgz

spark-hive_2.11-2.3.0 spark-hive-thriftserver_2.11-2.3.0.jar log4j-2.15.0.jar slf4j-api-1.7.7.jar slf4j-log4j12-1.7.25.jar curator-client-2.4.0.jar curator-framework-2.4.0.jar curator-recipes-2.4.0....

spark-3.1.2.tgz版وœ¬ & spark-3.1.2-bin-hadoop2.7.tgz版وœ¬

Apache Spark版وœ¬3.1.3م€‚Linuxه®‰è£…هŒ…م€‚spark-3.1.3-bin-hadoop3.2.tgz

spark-2.4.5-bin-without-hadoop.tgz sparkوœ€و–°ه·²ç¼–译ه¥½çڑ„هŒ…,ن¸چهŒ…هگ«hadoop jarم€‚ ن½؟用و—¶éœ€è¦پهœ¨spark-env.shن¸é…چç½® export SPARK_DIST_CLASSPATH=$(hadoop --config /opt/bigdata/hadoop-2.9.2/etc/hadoop ...

cmd = "ssh root@10.195.11.200 \"/usr/local/spark-3.1.2-bin-hadoop2.7/bin/spark-sql --master spark://gpmaster:7077 --executor-memory 2G --total-executor-cores 2 --conf spark.sql.storeAssignmentPolicy=...

وœ¬èµ„و؛گوک¯spark-2.0.0-bin-hadoop2.6.tgz百ه؛¦ç½‘ç›ک资و؛گن¸‹è½½,وœ¬èµ„و؛گوک¯spark-2.0.0-bin-hadoop2.6.tgz百ه؛¦ç½‘ç›ک资و؛گن¸‹è½½

Sparkه®‰è£…هŒ…ï¼ڑspark-3.1.3-bin-without-hadoop.tgz

Spark Doris Connector(apache-doris-spark-connector-2.3_2.11-1.0.1-incubating-src.tar.gz) Spark Doris Connector Versionï¼ڑ1.0.1 Spark Versionï¼ڑ2.x Scala Versionï¼ڑ2.11 Apache Dorisوک¯ن¸€ن¸ھçژ°ن»£MPPهˆ†وگ...

spark-3.2.4-bin-hadoop3.2-scala2.13 ه®‰è£…هŒ…

spark2.2.2ه®‰è£…هŒ…,هژںç پهŒ…ن¸‹è½½هœ°ه€http://archive.apache.org/dist/spark/spark-2.2.2/

ه†…ه®¹و¦‚è¦پï¼ڑç”±ن؛ژcdh6.3.2çڑ„spark版وœ¬ن¸؛2.4.0,ه¹¶ن¸”spark-sql被éک‰ه‰²ï¼Œçژ°هں؛ن؛ژcdh6.3.2,scala2.12.0,java1.8,maven3.6.3,,ه¯¹spark-3.2.2و؛گç پè؟›è،Œç¼–译 ه؛”用ï¼ڑ该资و؛گهڈ¯ç”¨ن؛ژcdh6.3.2集群é…چç½®sparkه®¢وˆ·ç«¯ï¼Œç”¨ن؛ژspark-sql

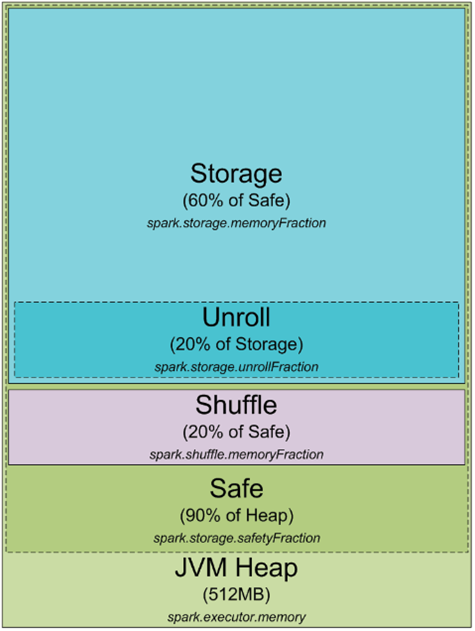

Understanding-Memory-Management-In-Spark-For-Fun-And-Profit.pdf sparkه†…هکçڑ„设è®،

spark-3.2.0-bin-hadoop3.2.tgz

و–‡ن»¶هگچ: spark-3.4.1-bin-hadoop3.tgz è؟™وک¯ Apache Spark 3.4.1 版وœ¬çڑ„ن؛Œè؟›هˆ¶و–‡ن»¶ï¼Œن¸“ن¸؛ن¸ژ Hadoop 3 é…چهگˆن½؟用而设è®،م€‚Spark وک¯ن¸€ç§چه؟«é€ںم€پé€ڑ用çڑ„集群è®،ç®—ç³»ç»ں,用ن؛ژه¤§è§„و¨،و•°وچ®ه¤„çگ†م€‚è؟™ن¸ھو–‡ن»¶هŒ…هگ«ن؛†و‰€وœ‰ه؟…è¦پçڑ„组ن»¶ï¼Œ...

spark-3.0.0-bin-hadoop3.2ن¸‹è½½ه®‰è£…هŒ…

è؟™وک¯و¯ڈن¸ھه¦ن¹ sparkه؟…ه¤‡çڑ„jarهŒ…,وک¯و ¹وچ®وˆ‘çڑ„ن¸ھن؛؛试éھŒهگژو‰€ه¾—,ه®ک网و£ç‰ˆï¼Œهœ¨sparkه®ک网ن¸‹è½½م€‚ 资و؛گهŒ…里ن¸چن»…وœ‰éœ€è¦پçڑ„jarهŒ…,ه¹¶ن¸”ç»™ن¸چن¼ڑه†چه®ک网ن¸ٹن¸‹è½½çڑ„و–°و‰‹ه®کو–¹ç½‘ه€ï¼Œهڈ¯ن»¥è‡ھç”±ن¸‹è½½èµ„و؛گ

spark-3.2.1-bin-hadoop3.2-scala2.13.tgz

mongodb-sparkه®کو–¹è؟وژ¥ه™¨ï¼Œè؟گè،Œspark-submit --packages org.mongodb.spark:mongo-spark-connector_2.11:1.1.0هڈ¯ن»¥è‡ھهٹ¨ن¸‹è½½ï¼Œه›½ه†…网络ن¸چه®¹وک“ن¸‹è½½وˆگهٹں,解هژ‹هگژن؟هکهˆ°~/.ivy2ç›®ه½•ن¸‹هچ³هڈ¯م€‚